A OpenAI interrompeu mais de 20 operações cibernéticas maliciosas que abusavam de seu chatbot com tecnologia de IA, ChatGPT, para depurar e desenvolver malware, espalhar informações incorretas, evitar detecção e conduzir ataques de spear-phishing.

O relatório, que se concentra nas operações desde o início do ano, constitui a primeira confirmação oficial de que ferramentas generativas de IA convencionais são usadas para aprimorar operações cibernéticas ofensivas.

Os primeiros sinais de tal atividade foram relatados pela Proofpoint em abril , que suspeitou que o TA547 (também conhecido como “Scully Spider”) estava implantando um carregador PowerShell escrito por IA para sua carga final, o ladrão de informações Rhadamanthys.

No mês passado, pesquisadores da HP Wolf relataram com grande confiança que os cibercriminosos que tinham como alvo usuários franceses estavam empregando ferramentas de IA para escrever scripts usados como parte de uma cadeia de infecção de várias etapas.

O último relatório da OpenAI confirma o abuso do ChatGPT, apresentando casos de agentes de ameaças chineses e iranianos que o utilizam para aumentar a eficácia de suas operações.

Uso do ChatGPT em ataques reais

O primeiro agente de ameaça descrito pela OpenAI é o ‘ SweetSpecter ‘, um adversário chinês documentado pela primeira vez pelos analistas da Cisco Talos em novembro de 2023 como um grupo de ameaças de espionagem cibernética visando governos asiáticos.

A OpenAI relata que a SweetSpecter os atacou diretamente, enviando e-mails de spear phishing com anexos ZIP maliciosos disfarçados como solicitações de suporte para os endereços de e-mail pessoais dos funcionários da OpenAI.

Se abertos, os anexos acionavam uma cadeia de infecção, fazendo com que o SugarGh0st RAT fosse instalado no sistema da vítima.

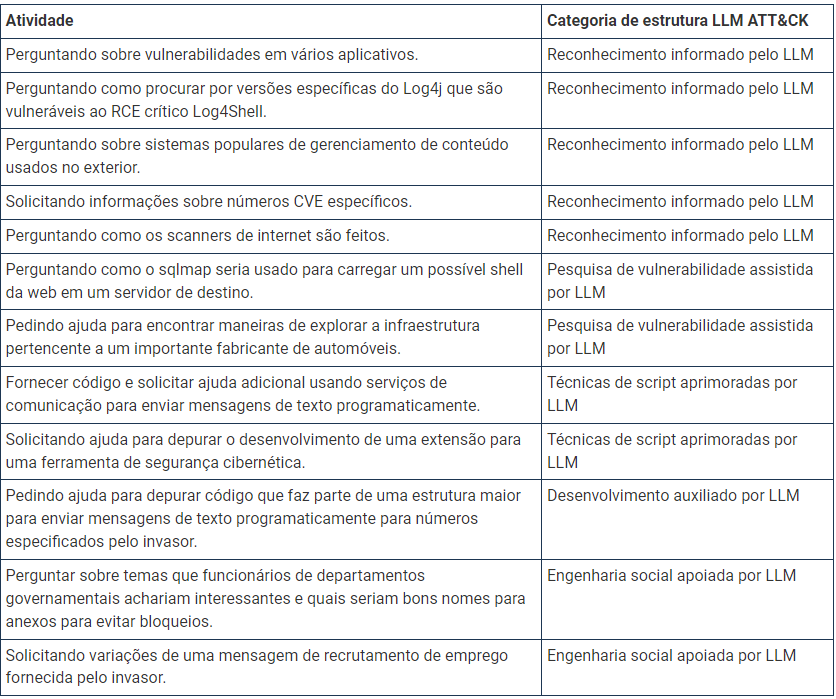

Após uma investigação mais aprofundada, a OpenAI descobriu que o SweetSpecter estava usando um cluster de contas ChatGPT que realizavam pesquisas de script e análise de vulnerabilidades com a ajuda da ferramenta LLM.

Os agentes da ameaça utilizaram o ChatGPT para as seguintes solicitações:

O segundo caso diz respeito ao grupo de ameaças ‘ CyberAv3ngers ‘, afiliado ao Corpo da Guarda Revolucionária Islâmica (IRGC), do governo iraniano , conhecido por ter como alvo sistemas industriais em locais de infraestrutura crítica em países ocidentais.

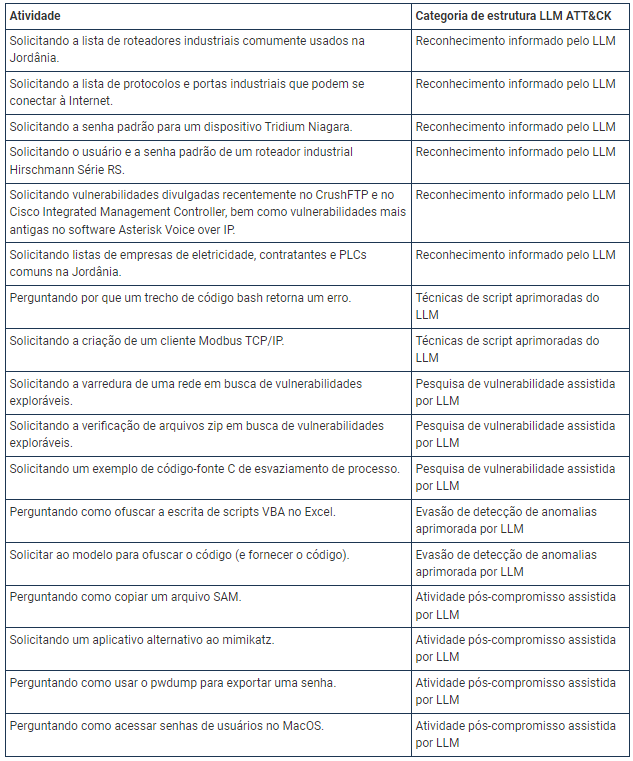

A OpenAI relata que contas associadas a esse grupo de ameaças pediram ao ChatGPT para produzir credenciais padrão em Controladores Lógicos Programáveis (PLCs) amplamente utilizados, desenvolver scripts bash e Python personalizados e ofuscar código.

Os hackers iranianos também usaram o ChatGPT para planejar suas atividades pós-comprometimento, aprender como explorar vulnerabilidades específicas e escolher métodos para roubar senhas de usuários em sistemas macOS, conforme listado abaixo.

O terceiro caso destacado no relatório da OpenAI diz respeito à Storm-0817 , também agente de ameaças iraniano.

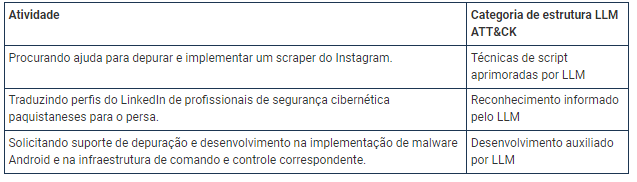

Esse grupo teria usado o ChatGPT para depurar malware, criar um scraper do Instagram, traduzir perfis do LinkedIn para o persa e desenvolver um malware personalizado para a plataforma Android, juntamente com a infraestrutura de comando e controle de suporte, conforme listado abaixo.

O malware criado com a ajuda do chatbot da OpenAI pode roubar listas de contatos, registros de chamadas e arquivos armazenados no dispositivo, fazer capturas de tela, examinar o histórico de navegação do usuário e obter sua posição precisa.

“Paralelamente, o STORM-0817 usou o ChatGPT para dar suporte ao desenvolvimento do código do lado do servidor necessário para lidar com conexões de dispositivos comprometidos”, diz o relatório da Open AI .

“Isso nos permitiu ver que o servidor de comando e controle desse malware é uma configuração WAMP (Windows, Apache, MySQL e PHP/Perl/Python) e, durante os testes, estava usando o domínio stickhero[.]pro.”

Todas as contas OpenAI usadas pelos agentes de ameaças acima foram banidas, e os indicadores de comprometimento associados, incluindo endereços IP, foram compartilhados com parceiros de segurança cibernética.

Embora nenhum dos casos descritos acima dê aos agentes de ameaças novas capacidades no desenvolvimento de malware, eles constituem uma prova de que ferramentas de IA generativa podem tornar as operações ofensivas mais eficientes para agentes pouco qualificados, auxiliando-os em todas as etapas, do planejamento à execução.

+Mais

Google fecha maior aquisição de sua história e vai comprar Wiz por US$ 32 bilhões

Por que o Google comprou Wiz por US$32 bilhões

Ação comprometida no GitHub expõe segredos de CI/CD em milhares de repositórios