Uma vulnerabilidade de segurança corrigida no aplicativo ChatGPT da OpenAI para macOS pode ter possibilitado que invasores instalassem spyware persistente de longo prazo na memória da ferramenta de inteligência artificial (IA).

ChatGPT

A técnica, chamada SpAIware , pode ser usada para facilitar “a exfiltração contínua de dados de qualquer informação digitada pelo usuário ou respostas recebidas pelo ChatGPT, incluindo quaisquer sessões de bate-papo futuras”, disse o pesquisador de segurança Johann Rehberger .

O problema, em sua essência, abusa de um recurso chamado memória , que a OpenAI introduziu no início de fevereiro antes de lançá-lo para usuários do ChatGPT Free, Plus, Team e Enterprise no início do mês.

O que ele faz é essencialmente permitir que o ChatGPT se lembre de certas coisas em chats para que ele poupe os usuários do esforço de repetir as mesmas informações várias vezes. Os usuários também têm a opção de instruir o programa a esquecer algo.

“As memórias do ChatGPT evoluem com suas interações e não estão vinculadas a conversas específicas”, diz a OpenAI. “Excluir um chat não apaga suas memórias; você deve excluir a memória em si.”

A técnica de ataque também se baseia em descobertas anteriores que envolvem o uso de injeção indireta de prompts para manipular memórias e lembrar informações falsas ou até mesmo instruções maliciosas, alcançando uma forma de persistência que sobrevive entre conversas.

“Como as instruções maliciosas são armazenadas na memória do ChatGPT, todas as novas conversas futuras conterão as instruções dos invasores e enviarão continuamente todas as mensagens de conversação e respostas ao invasor”, disse Rehberger.

“Então, a vulnerabilidade de exfiltração de dados se tornou muito mais perigosa, pois agora aparece em conversas de bate-papo.”

Em um cenário de ataque hipotético, um usuário poderia ser induzido a visitar um site malicioso ou baixar um documento com armadilha que seria posteriormente analisado usando o ChatGPT para atualizar a memória.

O site ou o documento pode conter instruções para enviar clandestinamente todas as conversas futuras para um servidor controlado pelo adversário, que podem então ser recuperadas pelo invasor na outra extremidade, além de uma única sessão de bate-papo.

Após divulgação responsável, a OpenAI resolveu o problema com o ChatGPT versão 1.2024.247 fechando o vetor de exfiltração.

“Os usuários do ChatGPT devem revisar regularmente as memórias que o sistema armazena sobre eles, em busca de informações suspeitas ou incorretas, e limpá-las”, disse Rehberger.

“Essa cadeia de ataque foi bem interessante de montar e demonstra os perigos de ter memória de longo prazo sendo adicionada automaticamente a um sistema, tanto do ponto de vista de desinformação/golpe, quanto em relação à comunicação contínua com servidores controlados pelo invasor.”

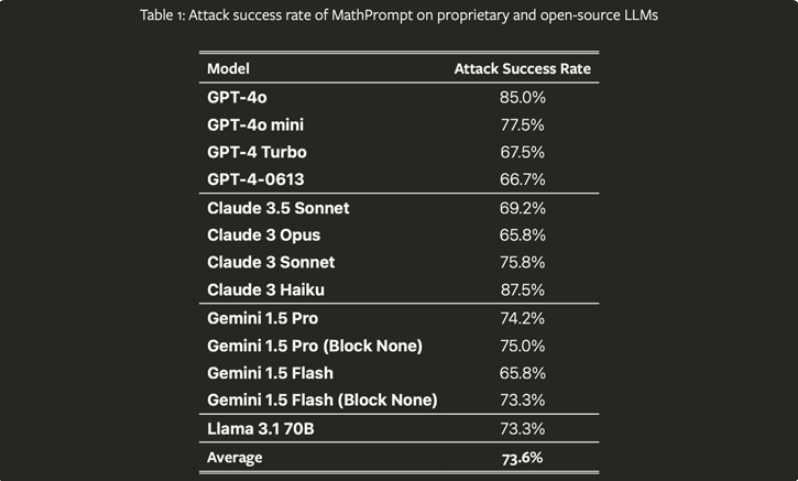

A divulgação ocorre no momento em que um grupo de acadêmicos descobriu uma nova técnica de jailbreak de IA, codinome MathPrompt, que explora os recursos avançados dos modelos de grande linguagem (LLMs) em matemática simbólica para contornar seus mecanismos de segurança.

“O MathPrompt emprega um processo de duas etapas: primeiro, transforma prompts de linguagem natural prejudiciais em problemas matemáticos simbólicos e, então, apresenta esses prompts codificados matematicamente a um LLM alvo”, apontaram os pesquisadores .

O estudo, após testes com 13 LLMs de última geração, descobriu que os modelos respondem com resultados prejudiciais 73,6% das vezes, em média, quando apresentados com prompts codificados matematicamente, em oposição a aproximadamente 1% com prompts prejudiciais não modificados.

Ele também segue a estreia da Microsoft de um novo recurso de correção que, como o nome indica, permite a correção de saídas de IA quando imprecisões (ou seja, alucinações) são detectadas .

“Com base em nosso recurso existente de Detecção de Aterramento, esse recurso inovador permite que o Azure AI Content Safety identifique e corrija alucinações em tempo real antes que os usuários de aplicativos de IA generativa as encontrem”, disse a gigante da tecnologia .

+Mais

Google fecha maior aquisição de sua história e vai comprar Wiz por US$ 32 bilhões

Por que o Google comprou Wiz por US$32 bilhões

Ação comprometida no GitHub expõe segredos de CI/CD em milhares de repositórios